RECORDING AND EVALUATING DATA

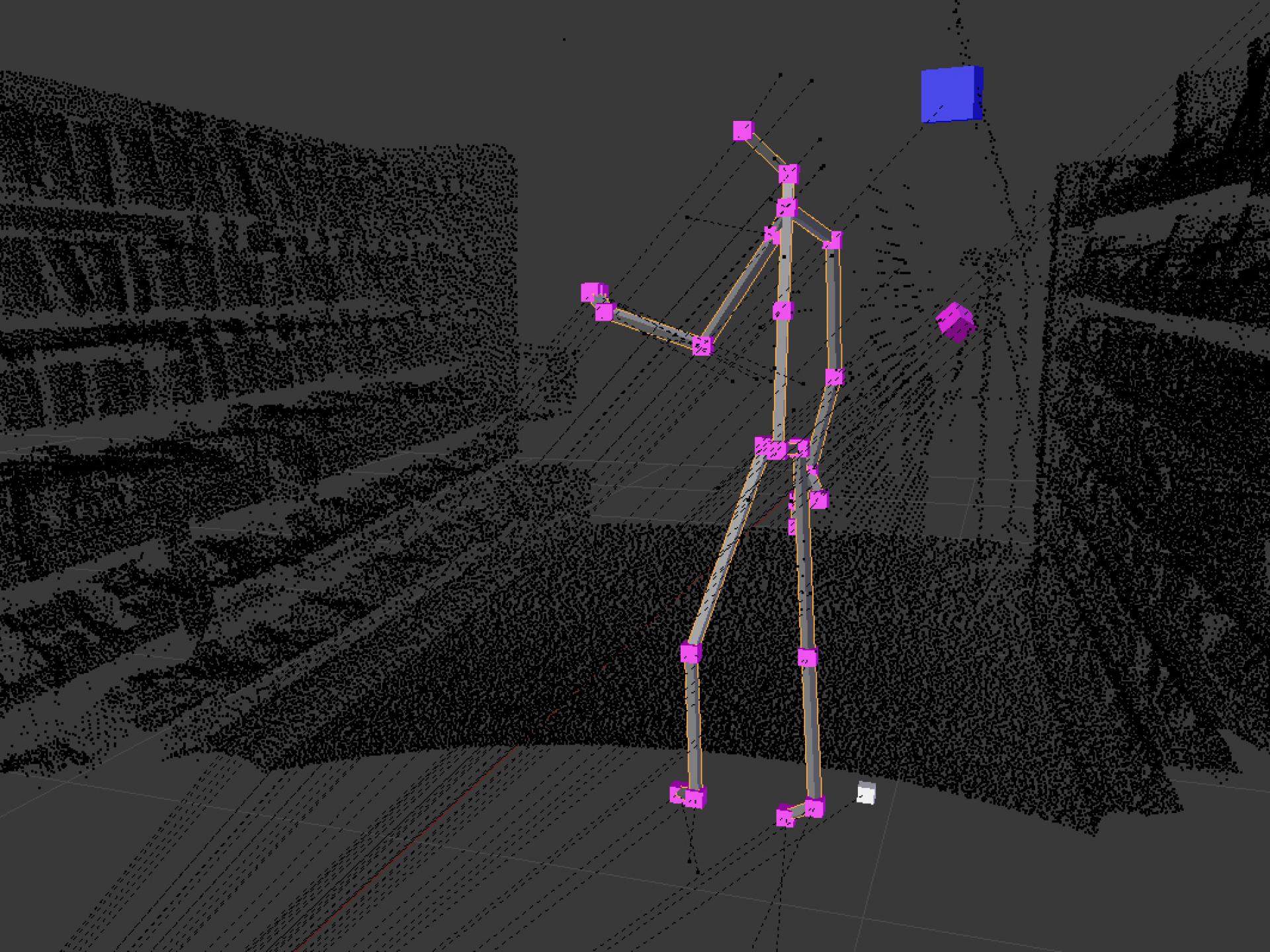

Sensors are set up in an area. A laser scanner creates a 3D representation of the real environment using one or more fused 3D point cloud images.

The test subject himself is a mobile sensor system. In the combination positions, poses, facial expressions, gestures and skin conductance are recorded synchronously and evaluated.

For evaluation, Deep Learning methods, OpenCV functions, Kinect 2 SDK functions and other third-party frameworks are used. All sensors are related to each other and located in the 3D representation.

POSITION, GESTIK UND MIMIK DES PROBANDEN BESTIMMEN

Mittels Eye-Tracking wird die Blickrichtung des Probanden im Raum festgestellt. Ein Sensor zur Messung des Hautleitwerts dient zur Einschätzung des aktuellen Stresslevels.

Je nach Größe und Beschaffenheit des realen Raumes erfassen mehrere Kombinationen aus Gigabit Ethernet Kameras und Kinect 2.0 Sensoren den Probanden aus unterschiedlichen Blickwinkeln. Daraus können seine Position, Gestik und Mimik bestimmt werden.

Zusätzlich können an Hotspots weitere Farbkameras aufgestellt werden, um die Mimikauswertung an diesen Positionen genauer zu erlauben. Alle Sensoren werden in die 3D Repräsentation aus den Laserscans kalibriert.

3D POSITION TRACKING

Based on several Gigabit Ethernet cameras and several Kinect 2.0 sensors as well as on the merged results of both, people are tracked in real space in real time.

SENSOR DATA FUSION

The data from Kinect 2.0 sensors, Gigabit Ethernet cameras, 3D laser scanners, colour cameras for facial expressions, sensors for skin conductance are fused, synchronized in time and spatially correlated.